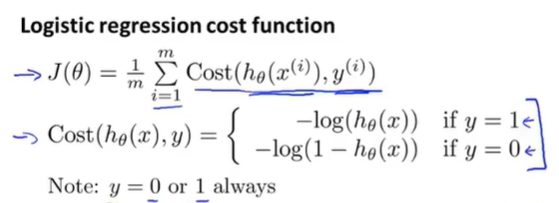

为了使代价函数用一条式子表示,可以写成如下:

![]()

(当y=1时,![]()

当y=0时,![]() )

)

(选择这个式子是因为这个式子是从统计学中的极大似然法得来的,它是统计学中为不同的模型快速寻找参数的方法,同时它还有一个很好的性质,它是凸的,这就对上了上一篇文章中的linear regression 的代价函数)

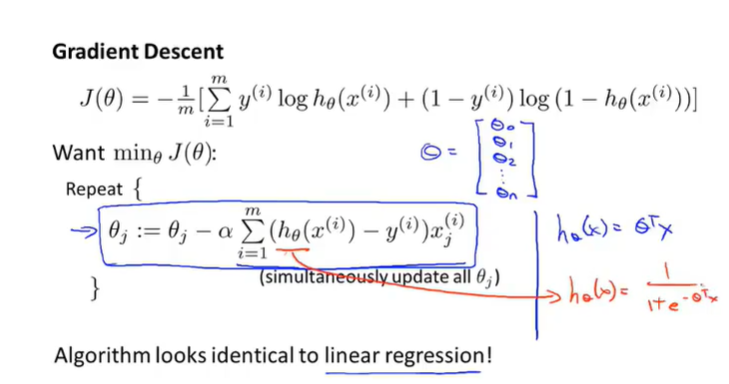

那我们 如何求theta呢?

使得cost function最小的theta是最佳的theta.求出theta后就可以预测了。

那么如何使得cost function最小呢?

采用梯度下降法。

式子看起来可能和linear regression的gradient descent一样,但是因为目标函数变了,所以不一样。

那么如何确保gradient descent 使其正常收敛呢,可以使用特征缩放来提高梯度下降的收敛速度。

原文:https://www.cnblogs.com/20WTZENG/p/14946184.html