发表时间:2021(ICML 2021)

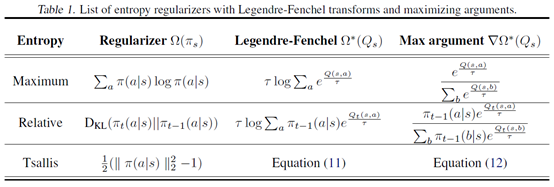

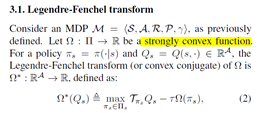

文章要点:之前PUCT的MCTS收敛速度是多项式的,这篇文章提出了凸正则化的方式将收敛速度提高到了指数级。主要修改的是PUCT这个采样策略,以及Q value的更新方式。通过Legendre-Fenchel transform把学Q变成了学一个对偶Q函数,

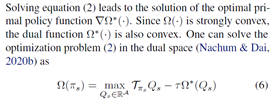

Q的更新变成了

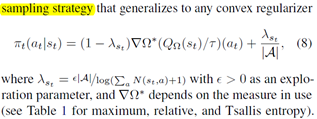

同时policy的学习改为

总结:基于Maximum Entropy Monte-Carlo Planning做的,里面的理论还要从这篇里找找。然后还有一些新知识,Tsallis entropy, Legendre-Fenchel transform,Bregman divergence。实验结果来看,也不是就完全比UCT好,有的好一点,有的也更差了。

疑问:其实理论很多都不懂,比如这个sampling policy为啥就写成这样了?证明也没看,现在看到证明就有点难受呀,感觉前面好多基本知识不了解,看不下去,不好的趋势啊。然后在Atari上做实验的时候,先用DQN预训练一个action value function给树搜索用,这是啥逻辑?就为了单比几种MCTS的优劣吗,不用MCTS结合RL来训?而且从结果看来,其实没有很大差别,几个算法都差不多。不过这个方式可能也说明了,以后所有RL的算法训练好了之后,其实都可以和MCTS套在一起,相当于多加了一层planning,只要解决model的问题,就可以无缝衔接了。

Convex Regularization in Monte-Carlo Tree Search

原文:https://www.cnblogs.com/initial-h/p/15077698.html