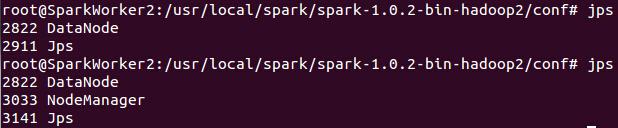

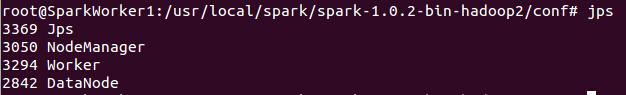

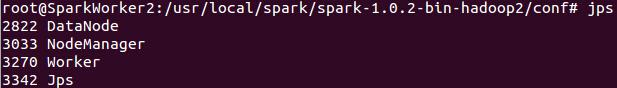

在SparkWorker1 和SparkWorker2上使用jps会看到如下进程信息:

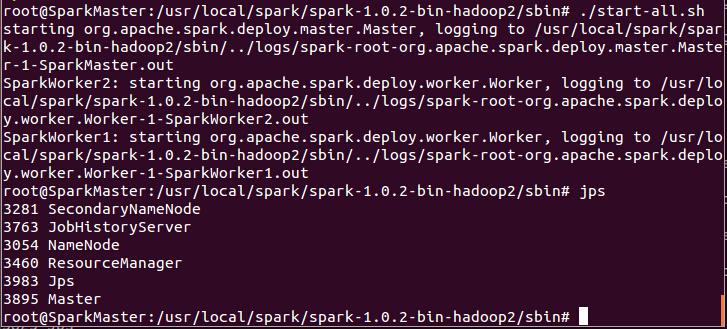

第二步:启动Spark集群

在Hadoop集群成功启动的基础上,启动Spark集群需要使用Spark的sbin目录下“start-all.sh”:

此时的SparkWorker1和SparkWorker2会出现新的进程“Worker”:

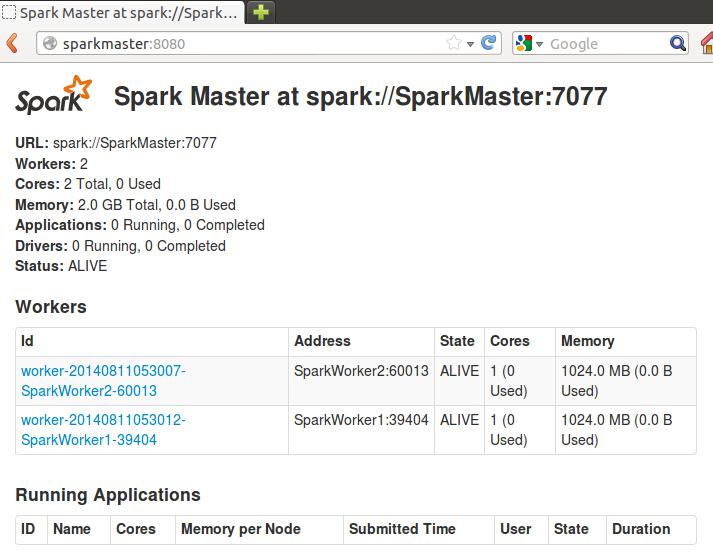

此时,我们可以进入Spark集群的Web页面,访问“http://SparkMaster:8080”: 如下所示:

从页面上我们可以看到我们有两个Worker节点及这两个节点的信息。

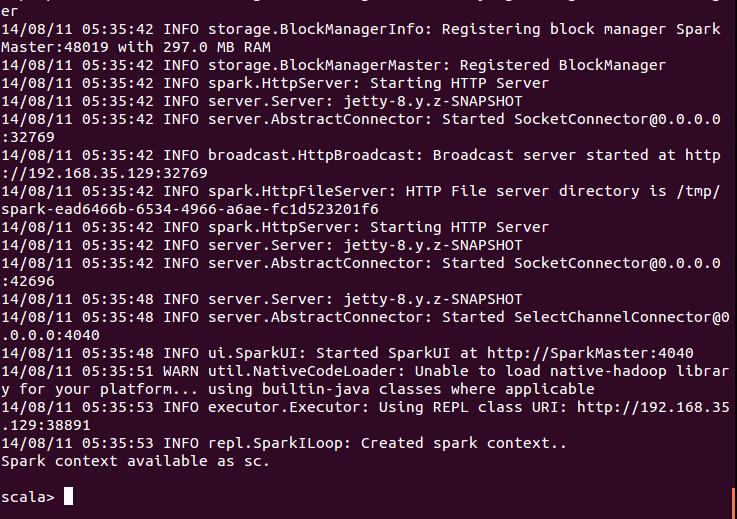

此时,我们进入Spark的bin目录,使用“spark-shell”控制台:

【Spark亚太研究院系列丛书】Spark实战高手之路-第一章 构建Spark集群(第五步)(10)

原文:http://my.oschina.net/u/1791057/blog/345665