主从架构:primary/secondary

主从架构:primary/secondary 双主模型:

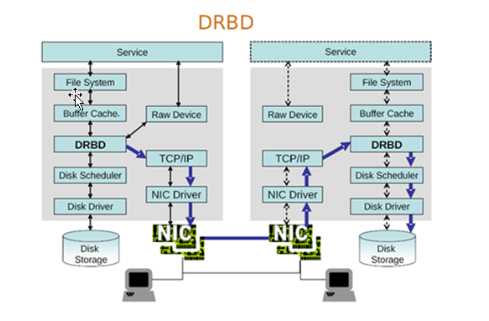

双主模型: 因为drdb工作在内核,故需要用户空间工具提供规则,所以它由用户空间工具和内核模块组成,就如同iptables和LVS一样.

因为drdb工作在内核,故需要用户空间工具提供规则,所以它由用户空间工具和内核模块组成,就如同iptables和LVS一样. 一定要使用与内核相匹配的包

一定要使用与内核相匹配的包 每一组drdb叫做drdb资源(资源名必须是小写字符),并以文件形式存放在/etc/drdb.d/资源名.res,资源之间以套接字方式互相通信

每一组drdb叫做drdb资源(资源名必须是小写字符),并以文件形式存放在/etc/drdb.d/资源名.res,资源之间以套接字方式互相通信 每一组drdb,主从所在的磁盘分区必须大小相等

每一组drdb,主从所在的磁盘分区必须大小相等

global {

usage-count no;

#是否给官方发送统计报告,这个不用说,还是关了吧

# minor-count dialog-refresh

disable-ip-verification

}

#定义drdb节点的共同点属性

common {

protocol C;

handlers

{

pri-on-incon-degr "/usr/lib/drbd/notify-pri-on-incon-degr.sh;

/usr/lib/drbd/notify-emergency-reboot.sh; echo b > /proc/sysrq-trigger ;

reboot -f";

pri-lost-after-sb "/usr/lib/drbd/notify-pri-lost-after-sb.sh;

/usr/lib/drbd/notify-emergency-reboot.sh; echo b > /proc/sysrq-trigger ;

reboot -f";

local-io-error "/usr/lib/drbd/notify-io-error.sh;

/usr/lib/drbd/notify-emergency-shutdown.sh; echo o > /proc/sysrq-trigger ;

halt -f";

# fence-peer

"/usr/lib/drbd/crm-fence-peer.sh";

# split-brain

"/usr/lib/drbd/notify-split-brain.sh root";

# out-of-sync

"/usr/lib/drbd/notify-out-of-sync.sh root";

# before-resync-target

"/usr/lib/drbd/snapshot-resync-target-lvm.sh -p 15 -- -c 16k";

#

after-resync-target

/usr/lib/drbd/unsnapshot-resync-target-lvm.sh;

}

startup {

#wfc-timeout

120;

#degr-wfc-timeout 120;

}

disk {

on-io-error

detach;

#fencing

resource-only;

}

net {

cram-hmac-alg "sha1";

shared-secret "mydrbdlab";

}

#定义同步速率

syncer {

rate 1000M;

}

}

resource web {

on

node1.magedu.com {

device /dev/drbd0;

disk /dev/sda5;

address 172.16.100.15:7789;

meta-disk internal;

}

on node2.magedu.com

{

device /dev/drbd0;

disk /dev/sda5;

address 172.16.100.16:7789;

meta-disk internal;

}

} 以上文件在两个节点上必须相同,因此,可以基于ssh将刚才配置的文件全部同步至另外一个节点。

以上文件在两个节点上必须相同,因此,可以基于ssh将刚才配置的文件全部同步至另外一个节点。

# scp /etc/drbd.d/*

node2:/etc/drbd.d/

# drbdadm create-md

web

#/etc/init.d/drbd start

# watch -nl "cat /proc/drbd"

version: 8.3.8 (api:88/proto:86-94)

GIT-hash:

d78846e52224fd00562f7c225bcc25b2d422321d build by

mockbuild@builder10.centos.org, 2010-06-04 08:04:16

0: cs:Connected ro:Secondary/Secondary ds:Inconsistent/Inconsistent C r----

ns:0 nr:0 dw:0 dr:0 al:0 bm:0 lo:0 pe:0 ua:0 ap:0 ep:1 wo:b oos:505964

# drbd-overview

0:web Connected Secondary/Secondary Inconsistent/Inconsistent C r----

# drbdadm primary --force

web 也可以在要设置为Primary的节点上使用如下命令来设置主节点:

也可以在要设置为Primary的节点上使用如下命令来设置主节点:

# mke2fs -j -L DRBD /dev/drbd0

#

mkdir /mnt/drbd

# mount /dev/drbd0

/mnt/drbd

# cp -r /etc/drbd.* /mnt/drbd

# umount /mnt/drbd

# drbdadm

secondary web --降级(下线)

# drbdadm primary web

--升级(上线)

# drbd-overview

0:web Connected

Primary/Secondary UpToDate/UpToDate C r----

# mkdir /mnt/drbd

# mount

/dev/drbd0 /mnt/drbd高可用集群(HA)之DRBD原理和基础配置,布布扣,bubuko.com

原文:http://www.cnblogs.com/aaa103439/p/3588459.html